Articles

Les agents IA dans vos sprints : comment les copilotes changent la signification d'un story point

Matt Lewandowski

Dernière mise à jour 10/02/20267 min de lecture

Le problème n'est pas l'inflation de la vélocité

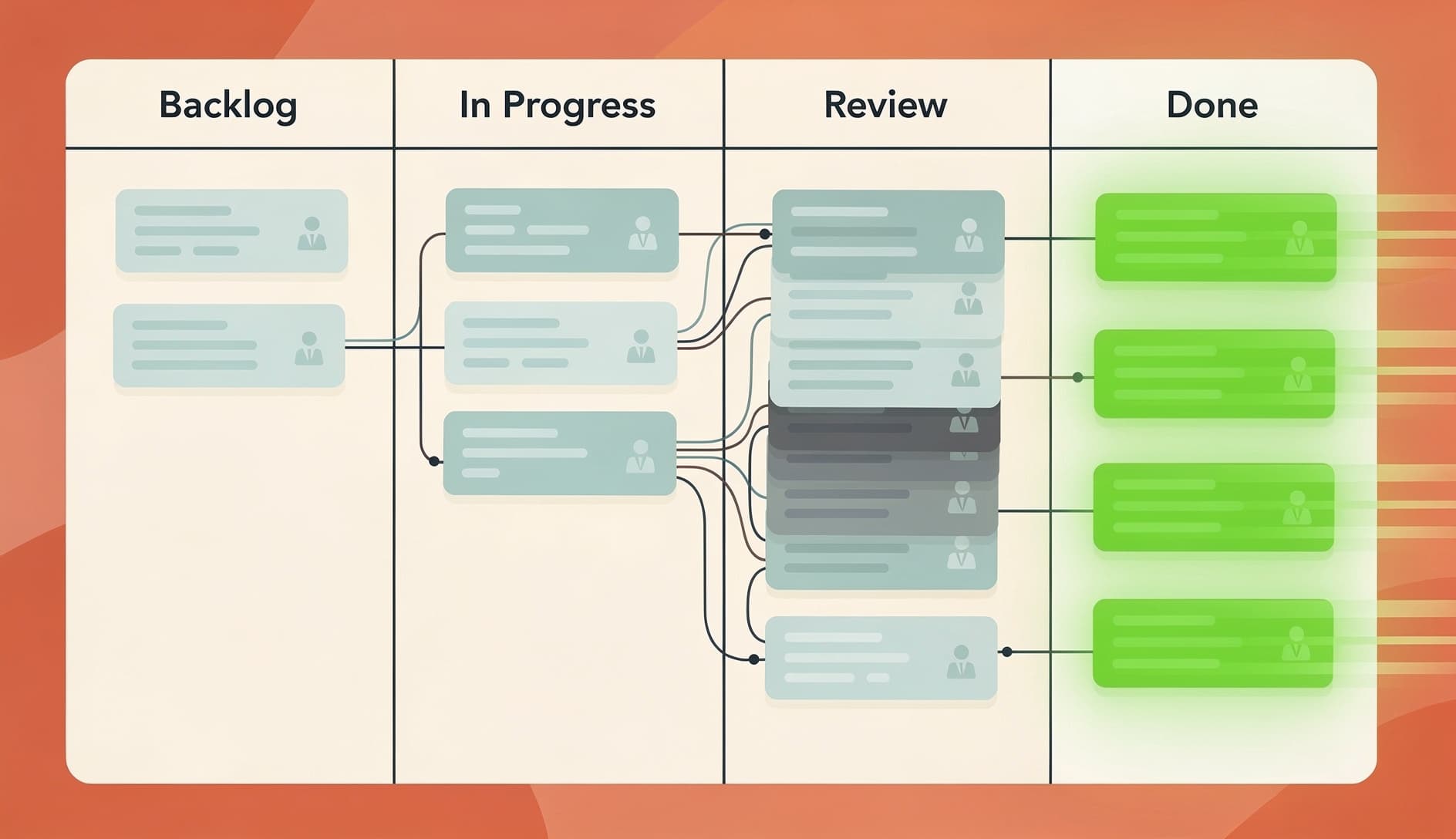

Ce que les équipes vivent réellement

Les story points ne sont pas cassés, mais ils ont besoin d'un recalibrage

Séparer "l'effort de codage" de "l'effort de livraison"

| Phase | Impact de l'IA |

|---|---|

| Comprendre les exigences | Minimal |

| Écrire du code | Élevé (2-10x plus rapide sur le travail routinier) |

| Revue de code | Négatif (plus de code à réviser, souvent de moindre qualité) |

| Tests | Modéré (l'IA peut générer des tests, mais quelqu'un doit les vérifier) |

| Intégration et déploiement | Minimal |

Recalibrer vos stories de référence

Autres façons de mesurer