Beiträge

KI-Agenten in Ihrem Sprint: Wie Copilots die Bedeutung von Story Points verändern

Matt Lewandowski

Zuletzt aktualisiert am 10/02/20267 Min. Lesezeit

Das Problem ist nicht die Velocity-Inflation

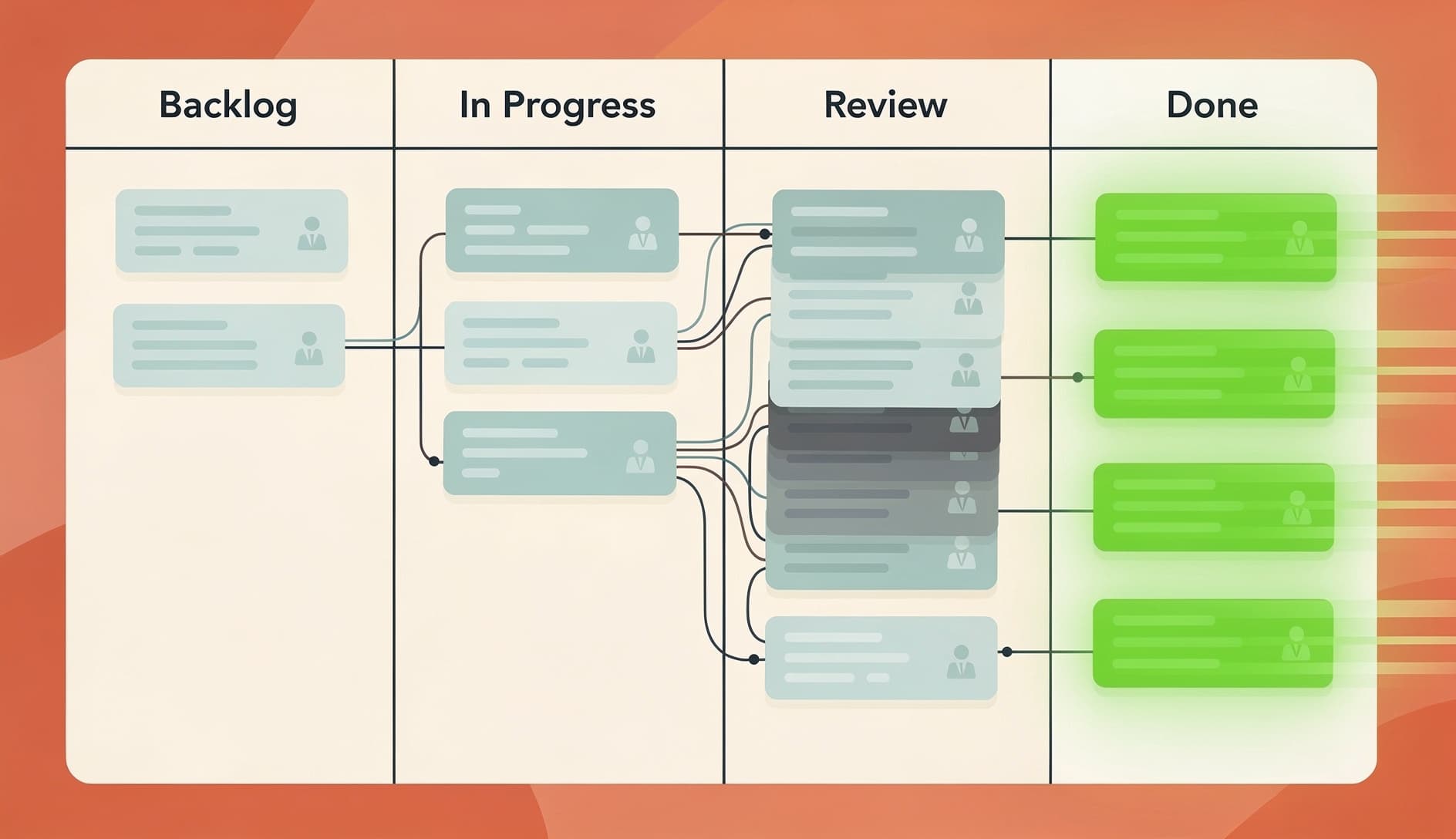

Was Teams tatsächlich erleben

Story Points sind nicht kaputt, aber sie brauchen eine Neukalibrierung

Trennen Sie "Coding-Aufwand" von "Lieferaufwand"

| Phase | KI-Einfluss |

|---|---|

| Anforderungen verstehen | Minimal |

| Code schreiben | Hoch (2-10x schneller bei Routinearbeit) |

| Code Review | Negativ (mehr Code zu reviewen, oft geringere Qualität) |

| Testen | Moderat (KI kann Tests generieren, aber jemand muss sie verifizieren) |

| Integration und Deployment | Minimal |

Kalibrieren Sie Ihre Referenz-Stories neu

Andere Messmethoden